オンラインワークショップにおける行動評価方法の研究

- 西村英伍 / 九州大学 芸術工学府芸術工学研究院

- Nishimura Eigo / Faculty of Design, Kyushu University

- 末吉孝 / 九州大学 芸術工学府

- Sueyoshi Kou / Graduate School of Design, Kyushu University

- 劉瑾 /

- Liu Jin

- 尾方義人 / 九州大学

- Ogata Yoshito / Faculty of Design, Kyushu University

Keywords: Workshop Design, Behavior Analysis

- Abstract

- Lorem Ipsum is simply dummy text of the printing and typesetting industry. Lorem Ipsum has been the industry's standard dummy text ever since the 1500s, when an unknown printer took a galley of type and scrambled it to make a type specimen book. It has survived not only five centuries, but also the leap into electronic typesetting, remaining essentially unchanged.

目的と背景

筆者らはワークショップにおける参加者の「コミュニケーション」と「集中」に着目し、それぞれの定量化によってワークショップの客観的評価とワークショップデザインへの応用を目指している。ここでコミュニケーションとは、参加者同士の会話を指し、視線が相手の顔に向けられていること、発話があることを基準としている。また集中とは、参加者の視線が資料や成果物に一定時間向けられていることを基準としている[1]。コミュニケーションと集中の持続時間や頻度等を分析することで、ワークショップが参加者にとって有意義なものであったかを評価するための指標を得られると考える。

新型コロナウイルス感染症の流行により対面でのワークショップの実施が困難となったことを受けて、ビデオ会議システムを用いたオンラインワークショップが検討実施されている。オンラインワークショップでは、参加者の顔とその周辺しか見えないため、従来のように運営者がワークショップの状態を感覚的に捉えることが困難になっていると考えられる。一方、オンラインワークショップでは終始参加者の顔がビデオで記録されているため、参加者の動きや視線からコミュニケーションの状態や集中の程度を動画解析によって分析することが可能である。

本研究ではオンラインワークショップ中の参加者の顔動画を、深層学習を用いた動画解析によって「コミュニケーション」と「集中」の点から分析し、ワークショップの状態を定量的に評価する方法の開発を目的とする。

方法

筆者らは、ワークショップ参加者の動画中の表情変化を数値化し時系列データを比較するために、深層学習ライブラリOpenPose[2]を用いた分析ツールを作成した。OpenPoseは図1に示すように、画像中の人の体や顔の全身のキーポイント25点、顔のキーポイント70点の座標を検出することができる。作成した分析ツールは、OpenPoseによって得られたキーポイントの座標データについて任意の点間距離または点によって囲まれる領域の面積を、動画の各フレームに対して時系列データとして算出し記録する機能を有している。

開発した分析ツールの性能や機能を確認するために、次の2つの予備実験を実施した。

発話・表情推定

作成した分析ツールにより発話や表情の推定が可能かを検討するために、図2に示すようにビデオ会議システムを使用したコミュニケーションを伴うゲームを4人で実施し解析の対象とした。ゲームは株式会社サムライトが提供するコミュニケーションゲームの中から体の動きが少なく、また道具を使用しない「それは何?」※1を採用した。

分析前に目視で動画を観察したところ、ゲーム中に参加者が笑う場面が複数回見られた。そこで、口の面積と眼の面積を各フレームに対して計算し、口の面積が大きく、かつ目の面積が小さい場合を笑顔をみなし、検出対象にすることとした。また、視線の指標として瞳の動きに着目した。図3に示す表情変化のプロットと動画を目視で比較したところ、発話中には口の面積が大きくなり、また笑っている間は口の面積が大きく、かつ目の面積が小さくなる傾向が見られた。一方、視線を推定するには瞳の動きだけでなく顔の方向を検出することで注目の対象をより高い精度で推定できるようになると考えた。

顔方向推定

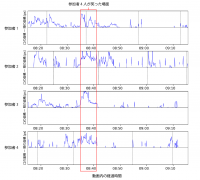

先の予備実験ではゲームのルールによって参加者の顔の動きがコントロールされていたが、実際のワークショップではより複雑なコミュニケーションが交わされる。そこで2回目の予備実験では、9人が参加するオンラインワークショップ中のディカッションの一部始終を録画し、解析の対象とした。

また1回目の予備実験の所感を反映して、顔の方向から視線を推定する機能を分析ツールに実装した。方法としては、AISTの人体寸法データベースから日本人青年層(18-29歳)男女平均値より、左右の外眼角、鼻尖、左右の口角、左右の耳の7箇所の三次元寸法を基に、二次元平面中の7点の座標から三次元空間の方向ベクトルを算出した。

図4のように、視線推定によって参加者が注目している対象を推定できるようになったが、注目の対象が何であるかが動画と解析結果からは分からない。遠隔ワークショップでは事前に各参加者の画面のレイアウトや、カメラと画面の位置関係等を確認しておく必要がある。また2回目の予備実験では、体動が大きく顔がカメラの画角から長時間外れてしまう状況が見られた。

今後の課題

以上2回の予備実験を通じて、オンラインワークショップ中に得られる参加者の顔動画からコミュニケーションと集中を推定するための方法を実装した。今後は、ワークショップのプログラムの中で参加者の視線の先に何があるのかを自然に把握し、ワークショップ中にその位置が変わらないようにコントロールすることと、顔がなるべく画角から外れないよう誘導するといった進行上の課題を解決していく。

脚注

※1: 「それは何?」とは、参加者の1人が出題者となり1つのものを思い浮かべ、他の参加者が「はい」または「いいえ」で答えられる質問をし、思い浮かべたものが何かを当てるゲームである。

参考文献

- [1] 劉瑾, 尾方義人, 藤智亮, 藤田徹郎, 光岡眞里, 田上暢顕, (2016)"レジリエンスとしての高齢者学習活動の行為分析", デザイン学会第五支部発表大会, 九州産業大学

- [2] Zhe Cao, Gines Hidalgo, Tomas Simon, Shih-En Wei, Yaser Sheikh (2019)"OpenPose: Realtime Multi-Person 2D Pose Estimation using Part Affinity Fields", arXiv:1812.08008

- [3]