機械学習

Machine Learning

機械学習(Machine Learning:ML) とは、データサイエンス、あるいは人工知能研究における手法の一つで、大量のデータを利用した反復的な学習(人間が行っている学習と同様のプロセス)によって、コンピュータ上にパターン認知や推論・生成のためのモデルを構築する技術です。

生成系AI(Generative AI)に利用されている Transformer もディープラーニングの一種で、非常に大規模な機械学習モデルを利用します。

- Discriminative AI:認識系AI / 識別系AI(文字・音声・画像認識等)

- Generative AI:生成系 AI(文章生成・楽曲生成・画像生成)

機械学習においてコンピュータに与えるのは、学習ルールと、学習素材のデータセットで、コンピュータ自身が大量のデータから推論のルールを自動的に学習します。例えば、ヒト、犬、猫の大量の画像と、その画像がヒトか、犬か、猫かの「答え」です。この画像はヒト、この画像は犬・・と大量に与えていくことで、識別する能力が学習され、その「経験」が豊富になることで、識別能力が上がっていくのです。小さな子供に「これは犬です」、「これは猫です」・・と教えていくのと同じ手順です。

このときコンピュータの中に自動的に出来上がる「入力と出力の関係づけ」のことを「モデル」というのですが、与えるデータが画像であれば、画像認識モデルができあがり、音声を与えつづければ、音声認識モデルができあがります。

従来、物事の判別は人手によるプログラミング( if 条件文)で実装していましたが、現在の AI 、例えば自動運転における画像解析、買い物行動の動作解析、オンラインショップのレコメンド機能、スパムメールの検知など、いわゆるパターン認知機能と呼ばれるものの大半は、この機械学習によって実装されています。

機械学習で可能になるのは大きく3つ、「予測」「発見」「生成」です。

- 予測:過去のデータから未知のデータに対する予測を行う(教師あり)

- 発見:過去のデータから未知のパターンを発見する(教師なし)

- 生成:過去のデータと条件入力から「それらしい」パターンを生成する

CONTENTS

はじめに

機械学習の位置づけ

「機械学習」の周辺には、データサイエンス、データマイニング、AIなど、様々な用語があり、それぞれの領域が交錯するため、位置付けが理解しづらいものになっています。基本的には「機械学習」はデータサイエンスの一手法で、その応用先として AI がある・・という感じです。

機械学習とデータマイニングの関係ですが、機械学習の立場からは、データマイニングは「教師なし学習」に位置付けれられる手法であり、データマイニングの立場からは機械学習はその一手法・・となります。

両者の目的の違いから言うと、機械学習の主目的(昨今の話題の中心)が、パターン認知のためのモデルをつくること、すなわち入力データを「既知」の特徴と照合させる(「教師あり」で訓練)ことにあるのに対し、データマイニングの目的は、データから「未知」の特徴を発見する(「教師なし」)ことにある・・と説明することができます。応用先という視点で言えば、機械学習の(今話題の)応用先は AIシステム。データマイニングの応用先は新たなビジネス・・ということができます。

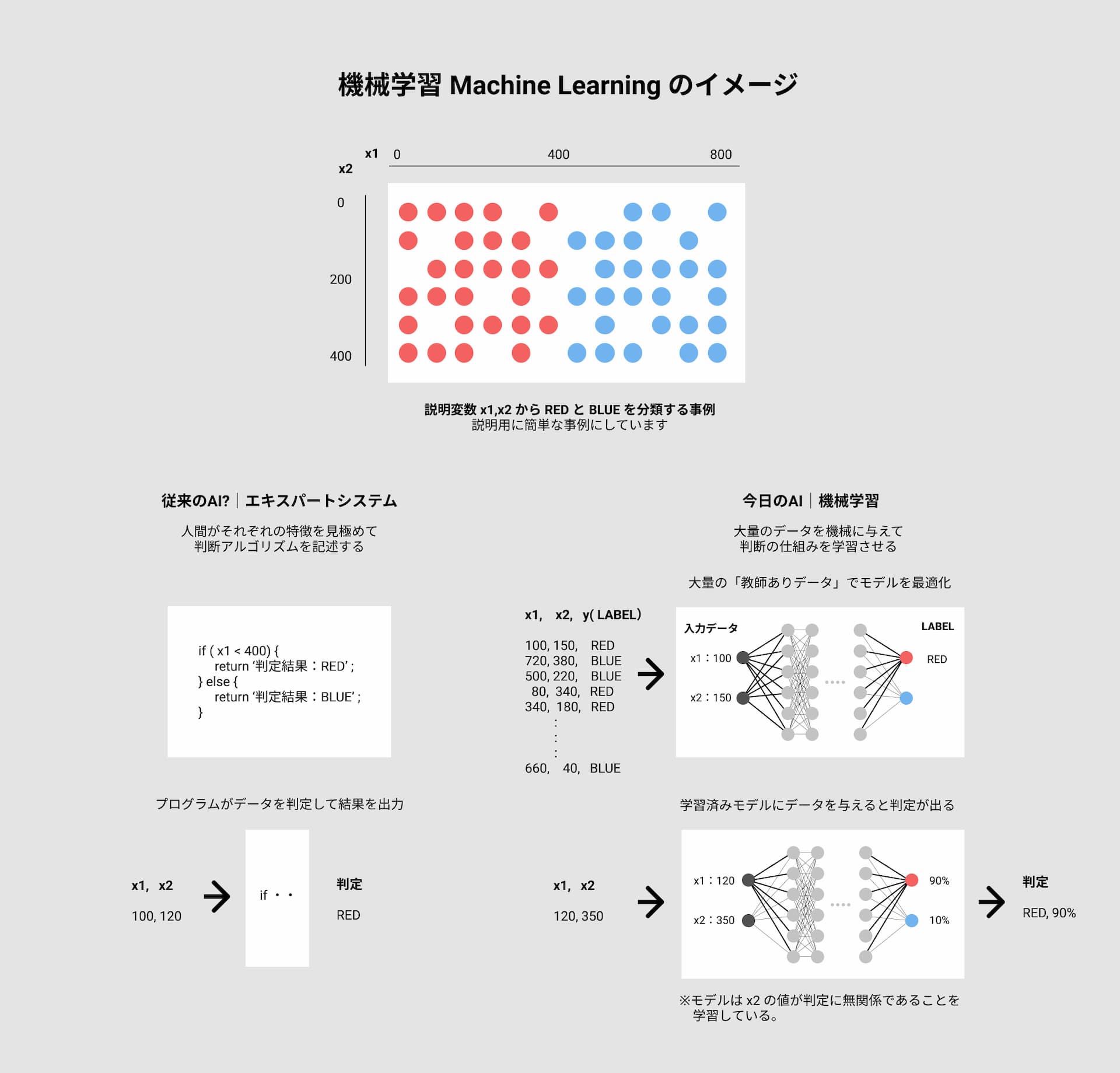

機械学習のイメージ

従来のAI(エキスパートシステム)と何が違うのか、そのイメージをざっくりと掴んでもらうための図解です。

機械学習の応用先

- 予測:数値予測、ニーズ・意図予測、マッチングなど

- 識別:情報の判断・仕分け・検索、音声・画像の認識、異常検知ど

- 実行:作業の自動化、表現生成、行動の最適化など

機械学習のタイプ

機械学習には、大きく4つのタイプがあります。

教師あり学習|Supervised learning

教師あり学習とは、学習のときに正解のラベルを使う手法で、既知の情報を用いて未来を予測する予測器を作ることを目指します。一般に問題(説明変数)と答え(目的変数)のセットからなる大量のデータを必要とします。主にカテゴリを予測する「分類」と、実数値を予測する「回帰」があります。手法としては、ニューラルネットワーク、線形回帰などがあります。

今最も実用化が進んでいるのがこの分野です。要するに、大量の過去のデータから現象を記述するモデルを作成し、それを用いて未来に起こることを予測する・・。これは基本的には、私たちの脳が「経験を積むことで、未来予測ができるようになる」という話と同じですが、コンピュータの記憶容量と処理の高速化が進んだことで、それが人知を超えたレベルで実現できるようになったのです。

教師なし学習|Unsupervised Learning

教師なし学習とは、学習のときに正解のラベルを使わずに、機械学習モデルに自力でデータの法則性を見つけさせる手法で、サンプルをグループ分けする「クラスタリング」や、高次元の変数(多変数)を低次元に減らす「次元削減(次元圧縮)」などがあります。k-means法、PCA などの手法があります。

半教師あり学習|Semi-supervised learning

半教師あり学習とは、学習の際に少量の正解ラベルつきデータとラベルのない大量のデータを使う手法を指します。正解ラベルつきのデータを用意するのにコストが掛かりすぎる場合などに有効です。

強化学習|Reinforcement learning

強化学習とは、正解ラベルの代わりに「報酬」を使う手法です。とるべき「行動」に無数の選択肢があり、明確な「答え」をあらかじめ与えることが難しい場合、「報酬」の大きな行動に高いスコア、「報酬」の少ない行動に低いスコアを与えていくことで、どう振る舞えば最大の報酬が得られるかを学習する・・というタイプのもので、囲碁や将棋などの AI に利用されています。Q-Learning や DQN(Deep Q Network)といった手法があります。

教師あり学習の手法

大きく2種類、主にカテゴリを予測する「分類(クラス分類)」と、実数値を予測する「回帰」があります。

分類

分類(クラス分類)とは、あるサンプルが与えられたときに、そのサンプルが所属するカテゴリを予測するものです。以下のような手法があります。

- ロジスティック回帰 > 詳細:LogisticRegression

注)「回帰」という文字を使いますが、「分類」の手法に属します。

- サポートベクターマシン > 詳細:SupportVectorMachine

- 決定木 > 詳細:DecisionTree

- ランダムフォレスト > 詳細:RandomForest

- ニューラルネットワーク > 詳細:NeuralNetwork

ディープラーニングはこの技術の応用(中間層を増やしたもの)です。

回帰

回帰とは、あるサンプルが与えられたときに、そのサンプルに関する何らかの数値を予測するものです。例えば、複数の都市サンプルの情報、例えば「人口」、「面積」、「税収」といった特徴と「犯罪率」をセットにしたデータで学習を行い、未知の都市の特徴からその犯罪率(実数値)を予測する・・といったものが回帰の問題です。以下のような手法があります。

- 線形回帰 > 詳細:LinearRegression

- 非線形回帰

- 以下、回帰の手法としても用いられます

- サポートベクターマシン

- ランダムフォレスト

- ニューラルネットワーク

教師なし学習の手法

クラスタリング

クラスタリングはサンプルを自動的にグループ分けする手法ですが、事前にカテゴリーを定義するのではなく、データの特徴のみを使って、それらをいくつかのグループに分ける・・というものです。よく似た言葉に「クラス分類」がありますが、クラス分類はカテゴリーが事前に決まっている「教師あり学習」に属するものです*1。

クラスタリングでは「いくつに分けるか」という「分類数」のみを分析者が事前に決定して、結果として見えてくる個々のグループに対しては、事後的に命名がなされます。「このデータは◯◯カテゴリーに属する」というような教師データ(事前データ)が存在しないのが、クラスタリングの特徴で、以下のような手法があります。

- k-means > 詳細:k-means

次元削減(次元圧縮)

次元削減とは文字通り「データの次元数を減らす」ことですが、例えば「生徒」の学力特性を説明するのに「国語・数学・理科・社会」という4つのデータ(これを4次元データと言います)を使うところを、「理系得点・文系得点」という2つのデータ(2次元)に落とし込んで説明するような操作を意味します。

一般に、説明変数(特徴量)が多いと、対象を捉えて識別することが難しくなりますが、例えば数学と理科の点数のように「連動する(相関が高い)」もの同士をまとめて「理系得点」として一つの数字で表現すれば、対象を捉えやすくなります。次元削減はこのような処理を大量のサンプルを使って自動的に行うものです。以下のような手法があります。

- 主成分分析(PCA) > 詳細:Statistics/PCA

- ニューラルネットワーク(オートエンコーダー系)

用語解説

説明変数と目的変数

関数モデルを y = f(X) と書いた場合の、X が説明変数で、y が目的変数です*2。

- 説明変数:explanatory variable

物事の原因となる変数。一般に X を使います。文献によっていろんな表現がありますが、以下、すべて同じ意味で使用されています。- 特徴量 feature / attribute

- 予測変数 predictor variable

- 独立変数 independent variable

- 目的変数:target variable

物事の結果(予測)となる変数。一般に y を使います。文献によっていろんな表現がありますが、以下、すべて同じ意味で使用されています。- ラベル label

- 応答変数 response variable

- 従属変数 dependent variable

- 付記:X vs Y の組み合わせは、以下のパターンが多いようです。

- 説明変数 vs 目的変数

- 特徴量 vs ラベル

- 予測変数 vs 応答変数

- 独立変数 vs 従属変数

学習用データとテストデータ

機械学習(教師あり)では、手持ちのデータを「学習用データ」と「テストデータ」で分けるのが一般的です。

手持ちのデータを全て学習用データとして使うと、そのデータに過度に適合したモデルができてしまい(過学習)、現実の予測に使おうとした場合に逆に精度が低くなってしまいます。そこで、一般には学習用データとテストデータに分割して、学習状況をテストデータでチェックしながら、テストデータに対して最も良い性能が出るように調整を繰り返します。

データの分割には、以下のような方法があります。

- Hold-out:全体を一定の比率(例えば7:3)で分割

- Cross Validation:全体をn個に分割して、n-1個を学習用、1個をテスト用として、これを順にローテーションしながら利用

- Leave One Out:上記の特殊版。1個だけテストデータとしてローテーション

目的関数と損失関数

教師あり学習では、入力 x に対して成分 w を用いて目的関数 y = f ( w , x ) を構築するとともに、正解 y に対する損失 L ( y , f ( w , x ) )を定義して、これが最小となるように成分を調整していきます。

目的関数の最適化問題を解くことは、すなわち、損失関数(誤差関数)を最小化すること・・と言えます。

例えば回帰問題では、一般に以下のような「二乗損失」を用います。

- 目的関数:y = f ( w, x )

- 損失関数:L ( y , f ( w, x ) ) = Σi ( yi − f ( w , xi) ) 2

参考:損失関数、評価関数、誤差関数、コスト関数、目的関数

https://zenn.dev/nekoallergy/articles/machinelearning-func

活性化関数

ニューラルネットワークにおいて線形変換(重み付き入力の総和)後に最終的な出力を決める関数のことを「活性化関数(Activation Function)」と言います。中間層と出力層では用いる関数が異なるのが一般的で、以下のように分類できます。

- 中間層で用いる活性化関数

- ステップ関数(形式ニューロン)

結果が閾値θよりも大きいか否かで、出力が単純に0または1の2値に区別されるものです。

f( x ) = 0(x≦θ), 1(x>θ) - 線形結合(単純パーセプトロン)

結果の値にバイアスを加えただけです。出力は線形連続になります。

f( x ) = ax + b - シグモイド関数

入力した値が大きければ大きいほど1に近づき、小さければ小さいほど0に近づく・・ロジスティック関数の特殊ケースにあたります。バックプロパゲーションを伴うニューラルネットワークで使われます。

f( x ) = 1 / ( 1 + exp(-x) ) - tanh関数

出力が−1から1なので出力がゼロになることでシグモイド関数に比べて学習の収束が容易になります。

f( x ) = ( exp(x) - exp(-x) ) / ( exp(x) + exp(-x) ) - ReLU(ランプ関数)

入力が 0以下のときは 0、1より大きいときは入力をそのまま出力します。

f( x ) = 0(x<θ), x(x≧θ) あるいは f( x ) = max( x, 0 )

- ステップ関数(形式ニューロン)

- 出力層で用いる活性化関数

- ソフトマックス関数

各出力 f( xi ) の値をすべての i について合計すると 100% になるもので、例えば画像認識問題で「猫:70%, トラ:20%, 犬:10%」 といったような回答を得たい場合に用います。(結果表示の事例)

f( xi ) = exp(xi) / Σj exp(xj ) - 恒等関数

最もシンプル、入力値をそのまま出力するものです。

f( x ) = x

- ソフトマックス関数

最適化アルゴリズム(オプティマイザ)

ニューラルネットの文脈では、最適化とは「出力の誤差が最小になるように調整すること」を意味します。誤差を表す関数は何らかのカーブを示しますが、このカーブをたどって、最下点に至るように、パラメータを調整するわけです。その方法には様々あります。以下リンクで紹介します。

- SGD:Stochastic Gradient Descent 確率的勾配降下法

- Momentum

- Nesterov Accelerated Gradient

- Adaptive Learning Rate

Momentum法と異なり、学習率を自動調整することを目指したのが Adaptive Learning Rate を用いた手法です。

Adagrad, RMSProp, Adadelta, Adam, Adamax, Eve, - YellowFin